Table des matières :

Mistral Large 2 : informations clés et ce qu’il faut retenir

Prêt à transformer votre entreprise avec l'IA ?

Découvrez comment l'IA peut transformer votre entreprise et améliorer votre productivité.

Caractéristiques techniques et avancées de Mistral Large 2

Mistral Large 2 se distingue par ses caractéristiques techniques de pointe, qui le positionnent à l'avant-garde des modèles d'intelligence artificielle. Grâce à une architecture optimisée et à une capacité de traitement impressionnante, il est capable de relever les défis les plus complexes avec une précision inégalée.

Architecture puissante et polyvalente

Doté de 123 milliards de paramètres, Mistral Large 2 offre une puissance de calcul exceptionnelle. Cette densité permet au modèle de traiter des tâches linguistiques complexes avec une grande finesse. Conçu pour fonctionner efficacement sur un seul nœud, il combine flexibilité et performance.

De plus, sa fenêtre de contexte étendue à 128 000 tokens assure une concordance et une pertinence remarquables lors de longues interactions, qu'il s'agisse de conversations prolongées ou de documents volumineux.

Excellence en multilinguisme et programmation

Mistral Large 2 excelle également dans le domaine du multilinguisme et du codage. Capable de gérer plus d’une dizaine de langues, dont le français, l'allemand et l'espagnol, il maintient une cohérence exemplaire dans les résultats.

En parallèle, il prend en charge plus de 80 langages de programmation tels que Python, Bash, Java, C++, JavaScript, offrant une précision et une fiabilité qui rivalisent avec les solutions les plus avancées. Cette polyvalence fait de Mistral Large 2 un outil puissant pour la génération de code et la résolution de problèmes mathématiques complexes, surclassant ainsi largement ses prédécesseurs dans divers benchmarks.

Comparaison des performances de Mistral Large 2 avec d’autres modèles

Mistral Large 2 établit une nouvelle référence en matière de performance, notamment sur le benchmark MMLU où il atteint une précision de 84,0%. Ce résultat le positionne favorablement en termes de rapport performance/coût parmi les modèles open-source.

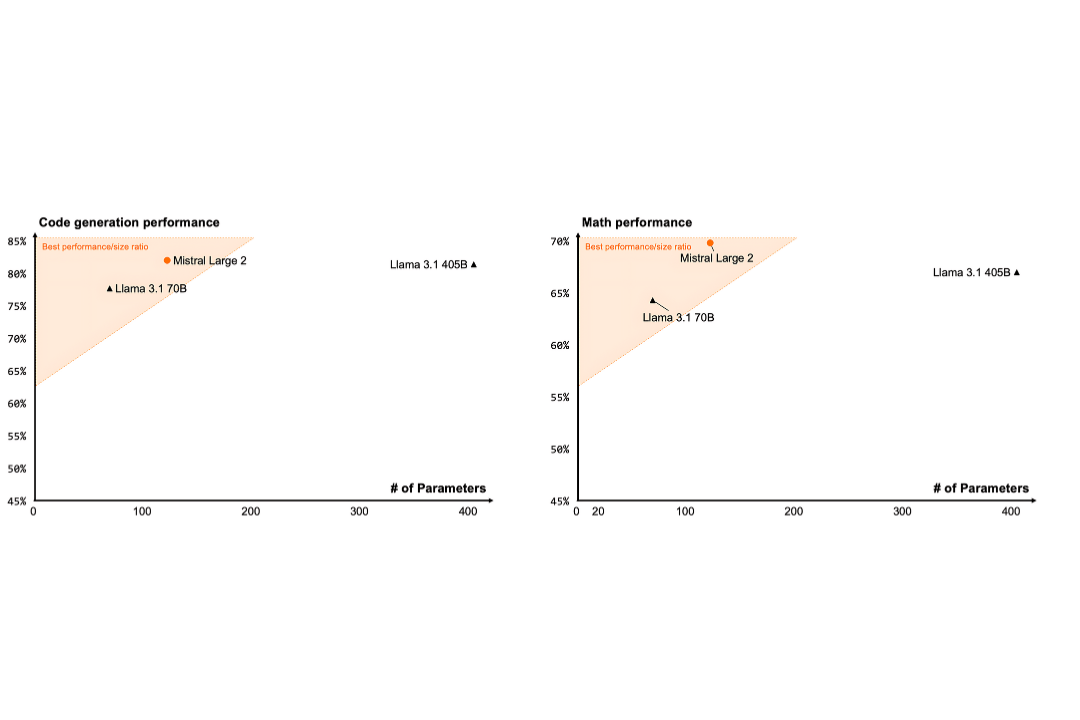

Génération de code

L'analyse comparative de la performance des modèles d'intelligence artificielle dans la génération de code révèle des résultats intéressants en fonction du nombre de paramètres. Le modèle Mistral Large 2, avec un nombre de paramètres relativement faible, affiche une performance remarquable de près de 85 %. Cette performance le place dans la catégorie des modèles offrant le meilleur rapport entre performance et taille, surpassant les autres modèles comparés.

En revanche, le modèle Llama 3.1 70B, malgré un nombre plus élevé de paramètres, montre une performance d'environ 75 %. Ce résultat, bien que respectable, est inférieur à celui de Mistral Large 2. De plus, Llama 3.1 405B, avec le plus grand nombre de paramètres parmi les modèles comparés, atteint une performance d'environ 80 %. Cependant, il se trouve en dehors de la zone de meilleur rapport performance/taille.

Ces résultats suggèrent qu'un nombre élevé de paramètres n'est pas toujours corrélé à de meilleures performances. Mistral Large 2 démontre qu'il est possible d'obtenir d'excellents résultats avec une architecture optimisée.

Suivi des instructions et réduction des hallucinations

Les capacités de Mistral Large 2 en matière de suivi des instructions ont été considérablement renforcées. Ce modèle excelle à maintenir la pertinence des échanges tout au long des interactions, sans ajouter de verbiage superflu. Cette amélioration permet une gestion plus efficace des dialogues complexes, garantissant des réponses précises et adaptées à chaque contexte.

Parallèlement, Mistral Large 2 a été spécialement conçu pour réduire les hallucinations et augmenter la précision des réponses. Grâce à des optimisations spécifiques, le modèle peut identifier clairement les situations où il manque d'informations nécessaires, ce qui l'aide à éviter les réponses incorrectes et les généralisations erronées. Ces améliorations se traduisent par une fiabilité accrue et une diminution des erreurs, rendant Mistral Large 2 un outil plus robuste pour des applications exigeantes.

Raisonnement et connaissances

Le résultat de Mistral Large 2 sur le test MMLU le positionne parmi les meilleurs, bien qu'il reste légèrement en deçà des performances des modèles concurrents tels que Llama 3.1 (88,6%) et GPT-4o (88,7%).

En ce qui concerne les défis Arc Challenge, Mistral Large 2 se distingue par ses scores élevés, atteignant 94,2% en 5-shot et 94,0% en 25-shot. Bien que GPT-4 obtienne un score impressionnant de 96,3% sur le test Arc Challenge (25-shot), Mistral Large 2 reste très compétitif et se distingue par son rapport coût-efficacité.

Ce modèle surpasse d’autres modèles puissants comme LLaMA 2 70B et GPT-3.5, montrant ainsi une capacité remarquable à comprendre et répondre à des questions dans divers contextes.

Appel de fonction

- Tout d’abord, qu'est-ce qu'un appel de fonction ?

Imaginez que vous demandez à un ordinateur de réaliser une tâche, par exemple "Effectue le calcul de 2 plus 3". Pour exécuter cette tâche, l'ordinateur va utiliser une fonction préprogrammée, ici une fonction d'addition. Cet appel de fonction est comme un ordre précis que l'on donne à la machine.

Si l’on jette un coup d’œil à la comparaison qui a été effectuée entre les modèles Mistral Large, Claude 3.5 Sonnet, Claude 3 Opus, GPT-4.0 et Mistral Large 2, nous pouvons vraiment voir la différence. Mistral Large 2 se distingue avec une précision d'environ 50 %, surpassant des modèles comme Claude 3.5 Sonnet, Claude 3 Opus et GPT-4.0, qui affichent des précisions autour de 45 %. En revanche, les modèles précédents comme Mistral Large présentent une précision relativement faible, approximativement 15 %.

- Et pourquoi est-ce important pour Mistral Large 2 ?

- Précision dans les tâches : grâce à l'appel de fonction, Mistral Large 2 peut exécuter des tâches très spécifiques avec une grande précision. Par exemple, il peut générer du code, traduire des langues, ou encore résoudre des équations mathématiques.

- Adaptabilité aux besoins de l'utilisateur : L'appel de fonction permet au modèle de s'adapter aux requêtes de l'utilisateur. Si vous demandez de générer un poème sur un sujet précis, le modèle pourra utiliser les bonnes fonctions pour créer ce poème.

- Efficacité pour les applications pratiques : Dans le monde réel, de nombreuses applications ont besoin d'exécuter des tâches précises. L'appel de fonction rend Mistral Large 2 très efficace pour ces applications.

Ainsi, Mistral Large 2 offre des performances remarquables et un excellent rapport coût-efficacité, le positionnant comme un concurrent sérieux de modèles comme Llama 3.1 et GPT-4. Bien que GPT-4 surpasse légèrement Mistral Large 2 sur certaines évaluations, ce dernier reste un choix très compétitif.

author

OSNI

Publié

août 31, 2024

Prêt à transformer votre entreprise avec l'IA ?

Découvrez comment l'IA peut transformer votre entreprise et améliorer votre productivité.