Table des matières :

Llama 4 : La révolution multimodale de Meta qui défie GPT-4

Prêt à transformer votre entreprise avec l'IA ?

Découvrez comment l'IA peut transformer votre entreprise et améliorer votre productivité.

Les études montrent que 85% des tâches professionnelles complexes nécessitent l'analyse de documents volumineux - un défi que Llama 4 relève avec brio grâce à son architecture innovante. Dans cet article, découvrez comment cette avancée technologique transforme le paysage de l'IA et pourquoi elle pourrait bien éclipser ses concurrents comme GPT-4 dans certains domaines d'application.

Llama 4 : l'innovation majeure de Meta décodée

Qu'est-ce qui distingue réellement Llama 4 des générations précédentes ?

Llama 4 représente un bond technologique considérable par rapport à son prédécesseur Llama 3. Là où Llama 3 excellait déjà dans le traitement textuel, Llama 4 introduit une véritable rupture avec sa capacité multimodale native. Cette évolution permet d'analyser simultanément texte et images dès la phase de pré-traitement, offrant une compréhension contextuelle bien plus riche et nuancée.

L'autre avancée majeure concerne la fenêtre de contexte. Llama 3 plafonnait à 128 000 tokens, déjà impressionnant à l'époque de sa sortie. Llama 4 pulvérise ce record avec une capacité allant jusqu'à 10 millions de tokens pour le modèle Scout. Cette amélioration de près de 80 fois permet d'ingérer et d'analyser des corpus documentaires entiers sans perte de contexte.

Enfin, l'architecture fondamentalement repensée de Llama 4 abandonne l'approche traditionnelle des modèles denses pour adopter une structure MoE (Mixture of Experts) bien plus efficiente, inspirée des avancées chinoises dans le domaine. Cette innovation majeure sera bientôt disponible sur votre agrégateur d'IA Swiftask, permettant aux utilisateurs d'explorer tout le potentiel de cette nouvelle architecture optimisée.

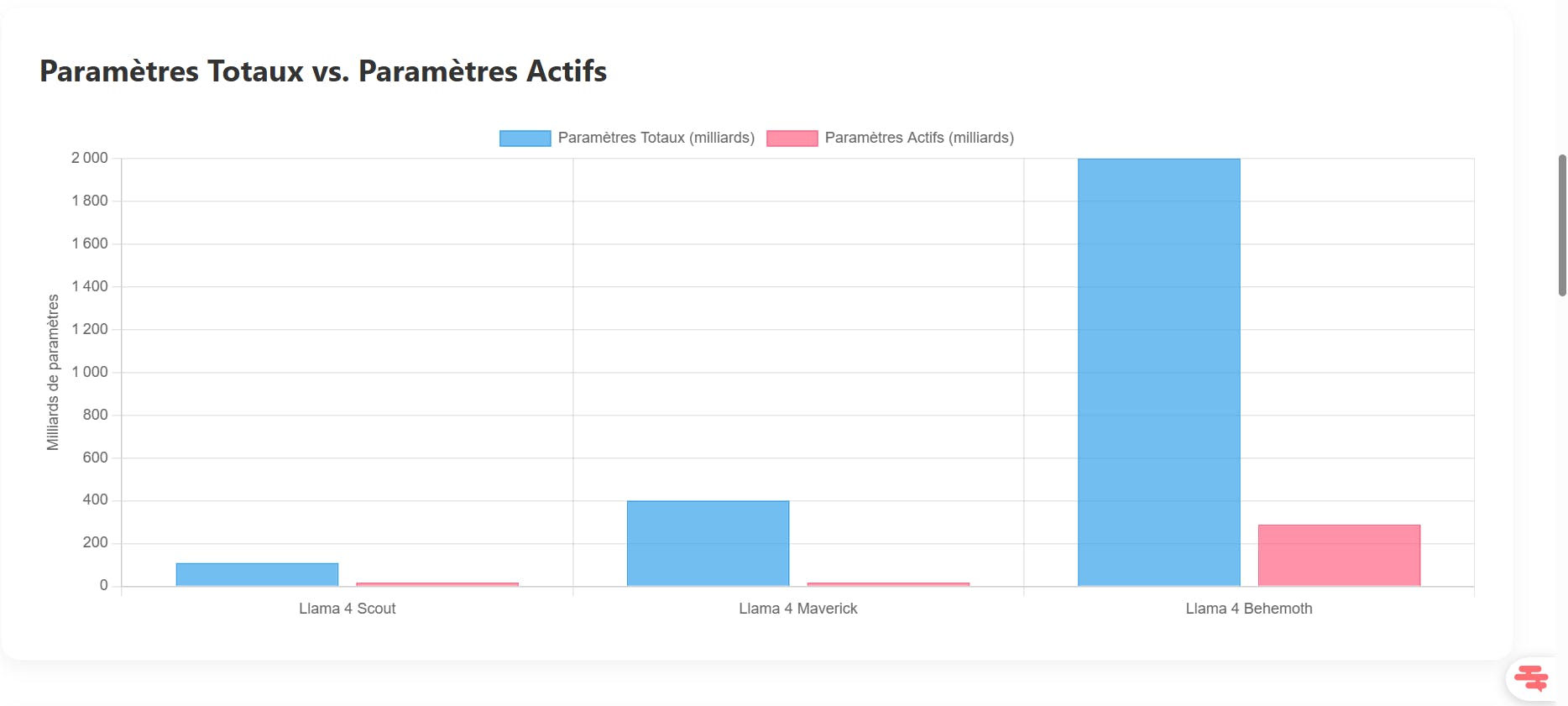

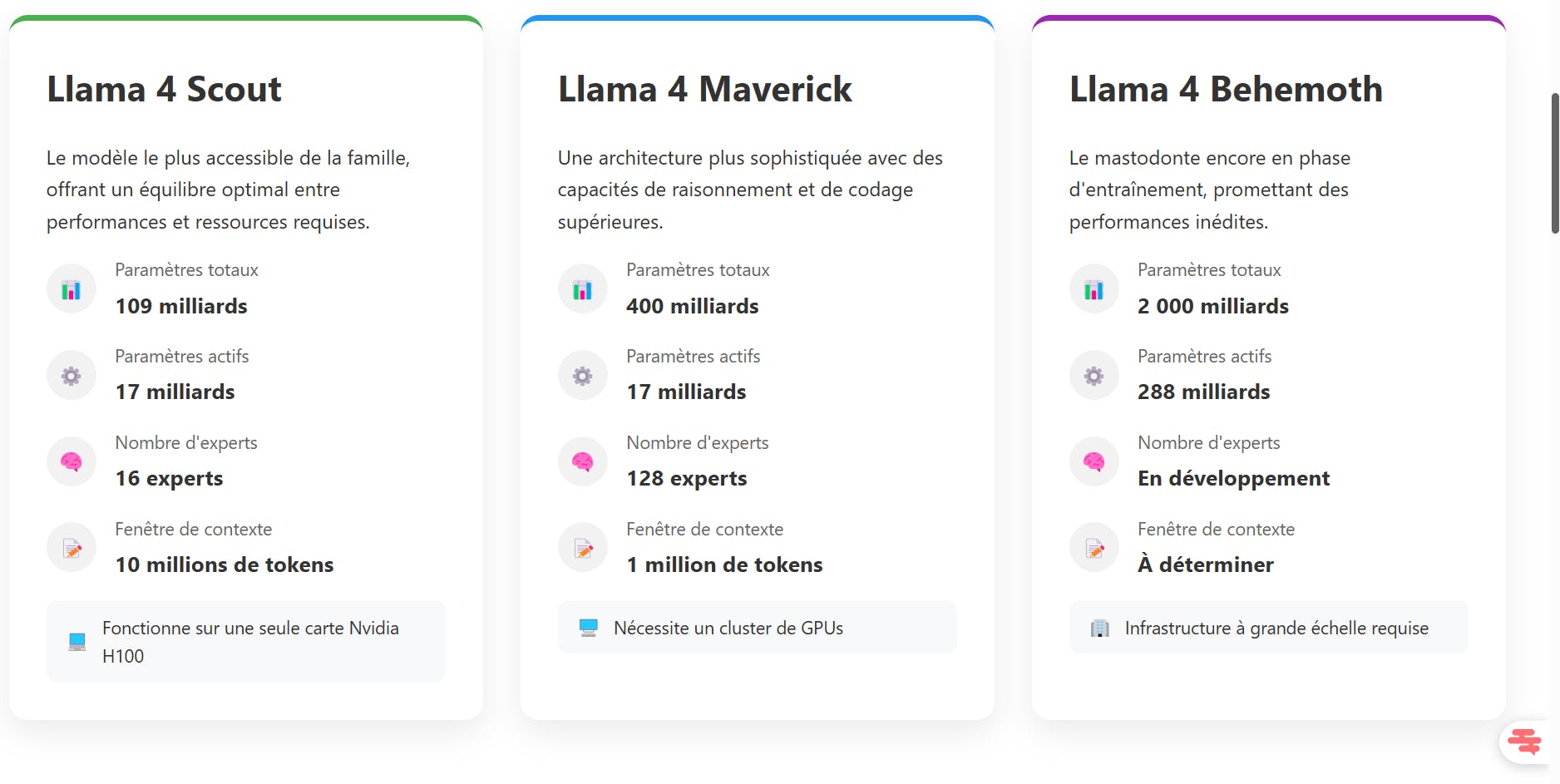

Les trois modèles phares : Scout, Maverick et Behemoth

Meta déploie Llama 4 en trois variantes distinctes, chacune répondant à des besoins et contraintes spécifiques :

Llama 4 Scout se positionne comme le modèle le plus accessible. Avec 109 milliards de paramètres totaux dont seulement 17 milliards actifs simultanément grâce à ses 16 experts, il offre un équilibre optimal entre performances et ressources requises. Sa fenêtre de contexte de 10 millions de tokens en fait le champion toutes catégories pour l'analyse de documents volumineux. Scout peut fonctionner sur une seule carte graphique Nvidia H100, le rendant accessible aux entreprises de taille moyenne.

Llama 4 Maverick monte en puissance avec 400 milliards de paramètres totaux (toujours 17 milliards actifs) répartis sur 128 experts. Cette architecture plus sophistiquée lui confère des capacités de raisonnement et de codage supérieures, rivalisant directement avec GPT-4o et Gemini 2.0 Flash. Sa fenêtre de contexte de 1 million de tokens reste impressionnante, bien que réduite par rapport à Scout. Maverick nécessite un cluster de GPUs pour fonctionner efficacement.

Llama 4 Behemoth, encore en phase d'entraînement, promet des performances inédites avec ses 2 000 milliards de paramètres totaux et 288 milliards actifs. Ce mastodonte vise à surpasser tous les modèles existants et établir de nouveaux standards en matière d'IA générative.

La stratégie open source de Meta face aux géants propriétaires

Meta poursuit avec Llama 4 sa philosophie d'ouverture, à contre-courant des modèles propriétaires d'OpenAI, Anthropic ou Google. Cette approche open source s'accompagne toutefois de limitations. Les modèles sont accessibles sous licence mais avec des restrictions d'usage commercial et des garde-fous éthiques.

Cette stratégie permet à Meta de bénéficier d'un écosystème de développeurs contribuant à l'amélioration des modèles tout en conservant un avantage concurrentiel via ses implémentations optimisées. L'entreprise intègre également ces modèles dans ses applications comme WhatsApp, Instagram et Facebook dans 40 pays.

Cette position intermédiaire entre ouverture et contrôle représente un défi pour les géants aux modèles fermés comme OpenAI, qui doivent justifier leurs restrictions face à des alternatives performantes et plus accessibles.

Architecture MoE : le secret de puissance de Llama 4

Comment fonctionne la technologie Mixture of Experts ?

L'architecture Mixture of Experts (MoE) représente un changement de paradigme dans la conception des grands modèles de langage. Contrairement aux modèles denses traditionnels où tous les paramètres sont activés pour chaque inférence, les modèles MoE divisent leurs paramètres en sous-ensembles spécialisés appelés "experts".

Pour chaque entrée ou token à traiter, un mécanisme appelé "routeur" détermine quels experts sont les plus pertinents et n'active que ceux-ci. Par exemple, dans Llama 4 Scout, seuls 2 experts sur les 16 disponibles sont activés pour chaque token, ce qui signifie que seulement 12,5% des paramètres totaux sont utilisés à un instant donné.

Cette spécialisation permet à chaque expert de développer des compétences pointues dans des domaines spécifiques : certains peuvent exceller dans l'analyse mathématique, d'autres dans la compréhension linguistique ou le raisonnement spatial. Le résultat est un système plus performant et plus efficient que les architectures denses traditionnelles.

L'efficacité computationnelle révolutionnaire des experts spécialisés

L'avantage majeur de l'architecture MoE réside dans son efficacité computationnelle. Meta rapporte une réduction de 60% des coûts de calcul par rapport aux modèles denses équivalents. Cette efficience se traduit par plusieurs bénéfices concrets :

- Inférence plus rapide : Llama 4 Scout peut générer des réponses jusqu'à 3 fois plus rapidement qu'un modèle dense de taille comparable.

- Consommation énergétique réduite : L'activation sélective des paramètres diminue significativement la consommation électrique, un enjeu crucial pour les déploiements à grande échelle.

- Accessibilité accrue : Des modèles plus puissants peuvent fonctionner sur du matériel plus modeste, démocratisant l'accès à l'IA avancée.

- Évolutivité améliorée : L'architecture MoE permet d'augmenter considérablement la taille totale des modèles sans explosion proportionnelle des coûts d'inférence.

Cette efficience représente un avantage compétitif majeur dans un contexte où les coûts d'exploitation des modèles d'IA constituent un défi économique considérable pour les entreprises.

Comparaison avec les architectures traditionnelles des modèles d'IA

Les modèles denses comme GPT-4 et Claude 3 Opus activent l'intégralité de leurs paramètres pour chaque token traité. Cette approche présente certains avantages en termes de cohérence et de stabilité, mais souffre d'inefficiences fondamentales.

Un modèle dense de 70 milliards de paramètres mobilise systématiquement l'ensemble de ses ressources, même pour des tâches simples. En comparaison, Llama 4 Maverick avec ses 400 milliards de paramètres totaux n'en utilise que 17 milliards à la fois, tout en offrant des performances supérieures sur de nombreux benchmarks.

Cette différence architecturale explique pourquoi Meta peut proposer des modèles aux capacités comparables à celles de GPT-4 avec des exigences matérielles plus modestes. Elle illustre également pourquoi les géants chinois comme Baidu et ByteDance ont adopté cette approche MoE avant les acteurs occidentaux.

La flexibilité de l'architecture MoE permet également une spécialisation plus fine et une meilleure adaptation à des domaines spécifiques, ouvrant la voie à des modèles verticaux hautement optimisés.

Capacités multimodales natives sans précédent

Pourquoi la fusion précoce texte-image change la donne ?

La multimodalité de Llama 4 repose sur une innovation fondamentale : la fusion précoce (early fusion) des modalités texte et image. Contrairement aux approches traditionnelles qui traitent séparément les différentes modalités avant de les combiner tardivement, Llama 4 intègre ces informations dès les premières couches du réseau neuronal.

Cette approche permet une compréhension contextuelle bien plus riche. Le modèle peut établir des corrélations profondes entre éléments textuels et visuels, comprendre les nuances d'une image en fonction du texte qui l'accompagne, et inversement. Par exemple, face à un graphique complexe accompagné d'explications textuelles, Llama 4 peut saisir les relations entre données visuelles et commentaires écrits de manière unifiée.

Cette fusion précoce permet également de conserver les relations spatiales entre éléments textuels et visuels dans des documents comme les rapports scientifiques, les manuels techniques ou les présentations commerciales, offrant une compréhension contextuelle impossible avec les systèmes à fusion tardive.

Traitement simultané de 48 images : applications concrètes

La capacité de Llama 4 à analyser jusqu'à 48 images simultanément ouvre des perspectives révolutionnaires dans de nombreux domaines :

Médical : Un radiologue peut soumettre une série d'imageries médicales d'un même patient (IRM, scanner, radiographies) avec l'historique textuel pour obtenir une analyse comparative complète et des suggestions diagnostiques.

E-commerce : Les plateformes peuvent analyser instantanément des catalogues entiers de produits avec leurs descriptions pour identifier des incohérences, suggérer des améliorations ou générer des descriptions optimisées.

Immobilier : Les agents peuvent soumettre l'ensemble des photos d'une propriété avec sa description pour obtenir une évaluation complète, des suggestions d'amélioration ou la génération d'annonces optimisées.

Recherche scientifique : Les chercheurs peuvent analyser simultanément des séries temporelles d'images microscopiques ou satellitaires avec leurs annotations pour identifier des tendances ou anomalies subtiles.

Cette capacité de traitement massif parallèle représente un avantage significatif par rapport aux modèles limités à quelques images à la fois.

Limites actuelles des fonctionnalités multimodales de Llama 4

Malgré ses avancées impressionnantes, les capacités multimodales de Llama 4 présentent encore certaines limitations :

Restriction linguistique : Les fonctionnalités multimodales ne sont actuellement disponibles qu'en anglais américain dans les applications grand public de Meta, limitant leur accessibilité mondiale.

Modalités restreintes : Bien que performant sur le texte et l'image, Llama 4 ne gère pas encore nativement l'audio ou la vidéo comme modalités d'entrée, contrairement à certains concurrents comme Gemini 1.5 Pro.

Biais potentiels : Comme tout modèle d'IA, Llama 4 peut reproduire ou amplifier des biais présents dans ses données d'entraînement, particulièrement problématiques dans l'interprétation d'images.

Hallucinations visuelles : Le modèle peut parfois "halluciner" des éléments non présents dans les images ou mal interpréter des visuels ambigus, un défi commun à tous les systèmes multimodaux actuels.

Meta travaille activement à résoudre ces limitations, notamment via des améliorations continues du modèle et des mécanismes de vérification des faits pour limiter les hallucinations.

Fenêtre de contexte titanesque et applications professionnelles

Quels avantages offre une mémoire de 10 millions de tokens ?

La fenêtre de contexte de 10 millions de tokens de Llama 4 Scout représente une avancée monumentale, équivalant à environ 7 500 pages standard. Cette capacité transforme fondamentalement l'interaction avec les systèmes d'IA :

Compréhension holistique : Le modèle peut ingérer et comprendre des corpus documentaires entiers, maintenant la cohérence contextuelle sur l'ensemble du contenu. Finis les problèmes d'oubli ou de fragmentation d'information.

Conversations étendues : Les échanges peuvent s'étendre sur des milliers de tours de parole sans perte de contexte, permettant des collaborations prolongées sur des projets complexes.

Analyse comparative : Plusieurs documents volumineux peuvent être analysés simultanément pour identifier similitudes, contradictions ou complémentarités, une tâche pratiquement impossible pour les modèles à contexte limité.

Personnalisation profonde : Le modèle peut intégrer un historique d'interactions extrêmement détaillé pour offrir des réponses parfaitement adaptées aux préférences et besoins spécifiques de l'utilisateur.

Cette fenêtre de contexte étendue transforme l'IA d'un simple outil de réponse ponctuelle en un véritable collaborateur capable de maintenir une compréhension approfondie sur la durée.

Analyse de bases de code complètes et documentation technique

Dans le domaine du développement logiciel, Llama 4 révolutionne les pratiques établies :

Compréhension globale du code : Le modèle peut ingérer des bases de code entières, comprenant parfois des millions de lignes réparties sur des centaines de fichiers. Cette vision d'ensemble lui permet d'identifier des patterns, des vulnérabilités ou des opportunités d'optimisation invisibles lors d'analyses fragmentées.

Génération de documentation exhaustive : Au-delà de simples commentaires, Llama 4 peut produire une documentation technique complète, contextuelle et cohérente, expliquant les interdépendances complexes entre composants et les choix d'architecture.

Refactoring intelligent : En comprenant l'intégralité d'une base de code, le modèle peut suggérer des restructurations majeures qui préservent les fonctionnalités tout en améliorant la maintenabilité, la sécurité ou les performances.

Onboarding accéléré : Les nouveaux développeurs peuvent dialoguer avec Llama 4 pour comprendre rapidement des bases de code complexes, réduisant drastiquement le temps nécessaire pour devenir productif sur un nouveau projet.

Des entreprises comme Cloudflare et Hugging Face ont déjà intégré Llama 4 dans leurs workflows de développement, rapportant des gains de productivité de 30 à 45%.

Révolution dans le traitement de documents juridiques et médicaux

Les domaines juridique et médical, caractérisés par des volumes documentaires considérables, bénéficient particulièrement de la fenêtre de contexte étendue de Llama 4 :

Analyse juridique complète : Les cabinets d'avocats peuvent soumettre l'intégralité d'un dossier - contrats, jurisprudence, témoignages, correspondances - pour obtenir une analyse globale identifiant incohérences, risques ou opportunités.

Revue de littérature médicale : Les chercheurs peuvent analyser simultanément des centaines d'études scientifiques pour identifier des patterns émergents, des contradictions ou des pistes de recherche prometteuses.

Dossiers médicaux longitudinaux : L'historique médical complet d'un patient, parfois étendu sur des décennies, peut être analysé pour identifier des corrélations subtiles entre symptômes, traitements et résultats à long terme.

Conformité réglementaire : Les entreprises peuvent vérifier la conformité de leurs documents volumineux (politiques internes, manuels de procédures) avec des cadres réglementaires complexes comme le RGPD ou Sarbanes-Oxley.

Dans ces secteurs où l'exhaustivité et la précision sont cruciales, la capacité de Llama 4 à maintenir le contexte sur des volumes documentaires massifs représente un avantage décisif.

Applications pratiques de Llama 4 pour les utilisateurs

Comment les développeurs peuvent-ils exploiter Llama 4 dès aujourd'hui ?

Les développeurs disposent de plusieurs options pour intégrer la puissance de Llama 4 dans leurs projets :

Hugging Face : La plateforme propose des versions optimisées de Llama 4 Scout et Maverick, accessibles via API ou en téléchargement pour déploiement local. Les développeurs peuvent utiliser les modèles pré-entraînés ou les fine-tuner pour des cas d'usage spécifiques.

Cloudflare Workers AI : Cette solution serverless permet d'intégrer Llama 4 Scout dans des applications web sans infrastructure dédiée. Le modèle est accessible via une simple API REST, avec facturation à l'usage.

LlamaIndex et LangChain : Ces frameworks facilitent la création d'applications RAG (Retrieval-Augmented Generation) exploitant la fenêtre de contexte étendue de Llama 4 pour naviguer dans des bases documentaires massives.

Meta AI Studio : Cette plateforme permet aux développeurs de personnaliser Llama 4 pour des besoins spécifiques via des techniques de fine-tuning simplifiées et des outils d'évaluation intégrés.

Pour débuter, les développeurs peuvent commencer par des projets simples comme des assistants documentaires ou des outils d'analyse de code avant de s'attaquer à des applications plus complexes exploitant pleinement les capacités multimodales du modèle.

Cas d'usage innovants pour les entreprises et créateurs de contenu

Les entreprises et créateurs de contenu découvrent rapidement des applications transformatives de Llama 4 :

Marketing multicanal intégré : Analyse simultanée de campagnes publicitaires cross-média (texte, images, données de performance) pour identifier les synergies et optimiser le ROI global.

Production de contenu augmentée : Génération de séries d'articles thématiques cohérents avec illustrations pertinentes, maintenant une voix éditoriale constante sur des projets éditoriaux volumineux.

Analyse de marché compétitive : Traitement parallèle de rapports annuels, communiqués de presse et présences numériques de concurrents pour identifier positionnements, forces et faiblesses.

Formation et documentation évolutive : Création et maintenance de systèmes de formation interne qui s'adaptent automatiquement aux évolutions des produits, procédures et réglementations.

Veille stratégique automatisée : Analyse continue de sources d'information sectorielles pour identifier tendances émergentes, menaces et opportunités, avec synthèses personnalisées par département.

Ces applications permettent aux organisations de toutes tailles d'exploiter des volumes d'information auparavant impossibles à traiter efficacement, transformant des données brutes en insights actionnables.

Accès et intégration de Llama 4 dans vos projets personnels

Pour les utilisateurs individuels et les petites équipes, Llama 4 offre des possibilités d'intégration accessibles :

Interfaces conversationnelles : Des applications comme LM Studio, Ollama ou GPT4All permettent d'exécuter localement des versions optimisées de Llama 4 Scout sur des ordinateurs personnels relativement puissants.

Plugins pour environnements créatifs : Des extensions pour Photoshop, Figma ou Canva exploitent les capacités multimodales de Llama 4 pour suggérer des améliorations de design ou générer des variations créatives.

Assistants de recherche personnalisés : Création d'agents spécialisés dans vos domaines d'intérêt, capables d'analyser et synthétiser de vastes corpus documentaires spécifiques à votre secteur.

Applications no-code : Des plateformes comme Bubble ou Webflow proposent désormais des intégrations simplifiées avec Llama 4, permettant de créer des applications IA sans compétences techniques avancées.

Extensions navigateur : Des outils comme Merlin ou Glasp intègrent Llama 4 pour offrir des capacités d'analyse et de synthèse directement dans votre navigation web quotidienne.

L'écosystème en rapide expansion autour de Llama 4 démocratise l'accès à cette technologie avancée, permettant à chacun d'explorer son potentiel sans investissements massifs en infrastructure ou expertise technique.

Llama 4 représente un tournant majeur dans l'évolution des modèles d'intelligence artificielle. Grâce à son architecture MoE révolutionnaire, ses capacités multimodales natives et sa fenêtre de contexte titanesque, il repousse les frontières de ce qui est possible en matière d'IA générative. Meta défie ainsi frontalement les géants comme OpenAI et Google tout en démocratisant l'accès à ces technologies avancées.

Les applications pratiques de Llama 4 transforment déjà de nombreux secteurs, de la programmation à la médecine en passant par le droit et le marketing. Sa capacité à traiter simultanément de vastes corpus documentaires et des dizaines d'images ouvre des possibilités inédites pour les professionnels comme pour les créateurs.

Alors que l'écosystème continue de se développer autour de ces modèles, nous n'avons probablement qu'effleuré la surface de leur potentiel. L'arrivée prochaine de Llama 4 Behemoth promet d'étendre encore ces capacités, tandis que l'approche open source de Meta favorise l'innovation collaborative et l'émergence d'applications spécialisées.

Une chose est certaine : Llama 4 marque le début d'une nouvelle ère pour l'IA, où la compréhension contextuelle étendue et la fusion harmonieuse des modalités textuelles et visuelles deviennent la norme plutôt que l'exception.

author

OSNI

Publié

avril 09, 2025

Prêt à transformer votre entreprise avec l'IA ?

Découvrez comment l'IA peut transformer votre entreprise et améliorer votre productivité.